Qwen2.5シリーズをデータ統一して学習

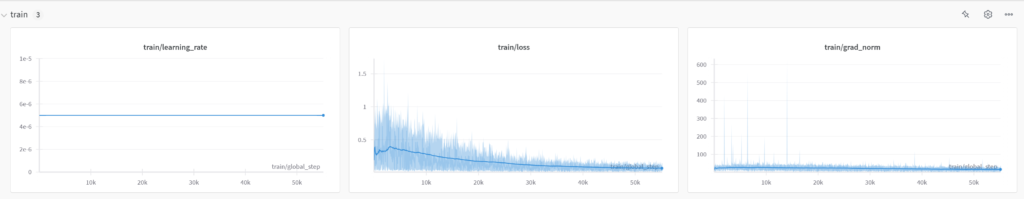

その際にバッチサイズを8で回していたところlossが0.5から下がらなかった。

いろいろ試したが結論はバッチ化するとバッチ内で平均して計算がおかしくなるようだった。

そのため1batchで学習したところすんなり通った。

メモ

学習が進まない場合は1batchにすると安全。

3B

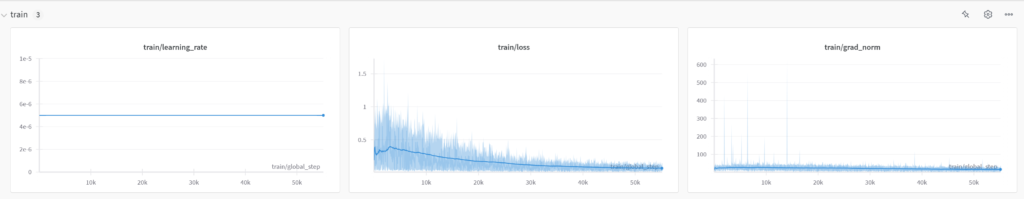

7B

メモ2

見てみると3Bより7Bのほうがnormが安定しているみたい。

パラメーター数が多い分1パラメーターあたりの重みが分散されてるとか?

Qwen2.5シリーズをデータ統一して学習

その際にバッチサイズを8で回していたところlossが0.5から下がらなかった。

いろいろ試したが結論はバッチ化するとバッチ内で平均して計算がおかしくなるようだった。

そのため1batchで学習したところすんなり通った。

学習が進まない場合は1batchにすると安全。

3B

7B

見てみると3Bより7Bのほうがnormが安定しているみたい。

パラメーター数が多い分1パラメーターあたりの重みが分散されてるとか?

プログラミングをそれとなく続けてきて歴だけは10年。

コーディングは基本的な命令文とクラスの概念は理解。

あとはライブラリなどを使ってそれとなく。

最近はAI関連を触ってます。